Biologische Algorithmen für künstliche neuronale Netze

Künstliche Intelligenz mit biologischem Vorbild ist ein spannender Forschungsbereich. In den letzten Jahren hat sich vor allem bei künstlichen neuronalen Netzen (KNN) viel getan. Sie wurden zum Beispiel durch neue Rechenmethoden wie Backpropagation deutlich besser. Doch dieser Ansatz ist zwar praktisch, aber schwer mit echten Gehirnprozessen zu vergleichen. Denn das Gehirn arbeitet anders als solche Programme. Deshalb suchen Forscher nach neuen Wegen, wie künstliche Intelligenz mit biologischem Vorbild funktionieren kann. Besonders biologische Modelle für künstliches Lernen werden dabei immer wichtiger.

Backpropagation und ihre Grenzen

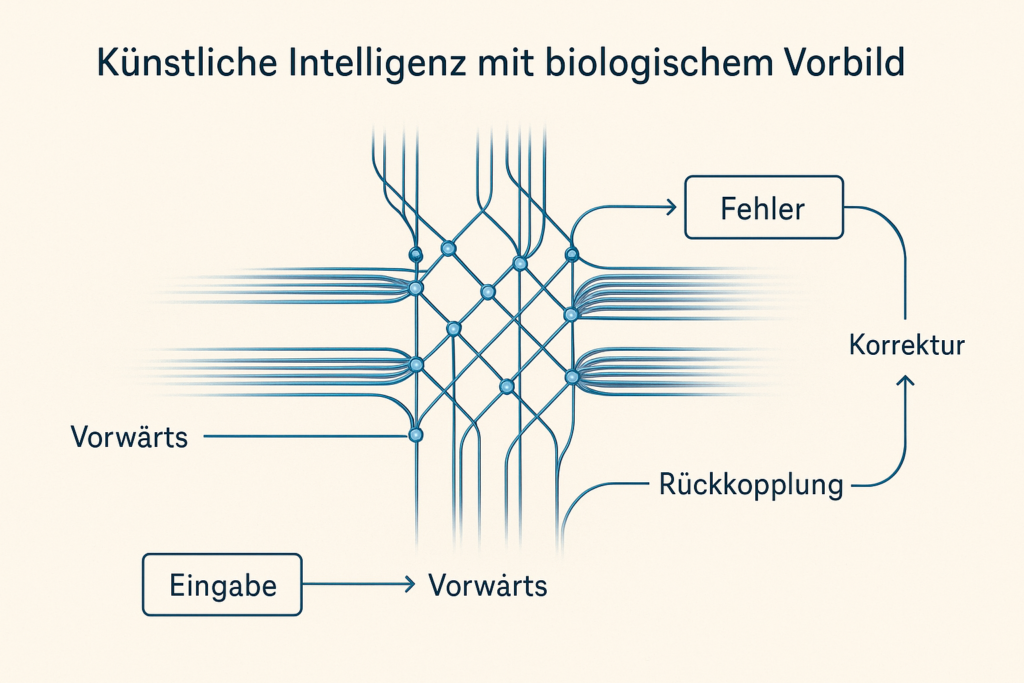

Backpropagation gibt es seit den 1980er-Jahren. Dabei wird geschaut, wo das Programm Fehler gemacht hat. Diese Fehler werden dann zurück durch das Netzwerk geleitet, um die Verbindungen zu ändern. Das klappt gut, aber ist technisch aufwendig. Außerdem ist es schwer, sich so etwas im Gehirn vorzustellen. Denn dort bekommen Nervenzellen nur einfache Signale von Nachbarzellen – nicht alle Infos auf einmal. Diese Unterschiede zeigen deutlich: Wie das Gehirn lernt – neue KI-Modelle im Vergleich helfen, bessere Lösungen zu finden.

Biologisch passende Alternativen

Ein anderer Vorschlag ist die sogenannte Equilibrium Propagation. Hier feuern Zellen im Netzwerk so lange hin und her, bis ein Gleichgewicht entsteht. Stimmt etwas nicht, wird das durch Rückmeldungen im Netzwerk verbessert. Das ist ein bisschen wie Backpropagation – nur einfacher und näher an dem, was im Gehirn passiert. Dadurch bringen solche Methoden künstliche Intelligenz mit biologischem Vorbild einen großen Schritt voran.

Predictive Coding als Lernmodell

Beim Predictive Coding macht das Gehirn ständig Vorhersagen. Es prüft, ob die Realität zur Erwartung passt. Wenn nicht, sendet es Korrekturen durch das Netzwerk. Diese Methode wurde für KI angepasst. Sie ist fast so gut wie Backpropagation – aber einfacher aufgebaut. Auch deshalb geht es hier darum, künstliche Intelligenz mit biologischem Vorbild zu schaffen. Dieses Verfahren zählt ebenfalls zu den biologischen Modellen für künstliches Lernen, die Forscher genau untersuchen.

Der Beitrag von Pyramidenzellen

Ein weiteres Beispiel kommt aus der Hirnforschung: sogenannte Pyramidenzellen. Diese Nervenzellen haben zwei Arten von Verästelungen. Sie können Informationen sowohl vorwärts als auch rückwärts verarbeiten. Das hilft beim Lernen. Durch diese Struktur arbeiten Netzwerke schneller und genauer. Solche Ideen liefern die Grundlage für KI inspiriert vom menschlichen Gehirn, wie sie heute in neuen KI-Modellen umgesetzt wird.

Fazit

Backpropagation ist weiterhin sehr nützlich. Trotzdem werden neue Wege mit biologischem Vorbild immer beliebter. Methoden wie Equilibrium Propagation und Predictive Coding zeigen, dass künstliche Intelligenz mit biologischem Vorbild keine Zukunftsvision mehr ist – sondern schon heute erforscht wird. Diese Entwicklungen helfen nicht nur der Technik, sondern auch dem Verständnis des Gehirns. Deshalb lohnt es sich, wie das Gehirn lernt – neue KI-Modelle im Vergleich weiter zu erforschen.

Quellen:

- Lillicrap, T. P., Santoro, A., Marris, L., Akerman, C. J., & Hinton, G. E. (2016). Random synaptic feedback weights support error backpropagation for deep learning. Nature Communications, 7, 13276. https://pubmed.ncbi.nlm.nih.gov/27824044/

- Millidge, B., Tschantz, A., & Buckley, C. L. (2020). Predictive coding approximates backpropagation along arbitrary computation graphs. arXiv preprint, arXiv:2006.04182. https://scispace.com/pdf/predictive-coding-approximates-backprop-along-arbitrary-311ccucv.pdf

- Nayebi, A., Bear, D., Kubilius, J., Kar, K., Ganguli, S., Sussillo, D., & Yamins, D. (2020). Identifying learning rules from neural network observables. arXiv preprint, arXiv:2010.11765v2. https://pubmed.ncbi.nlm.nih.gov/27824044/

- Scellier, B., & Bengio, Y. (2017). Equilibrium propagation: Bridging the gap between energy-based models and backpropagation. Frontiers in Computational Neuroscience, 11, 24. https://www.frontiersin.org/journals/computational-neuroscience/articles/10.3389/fncom.2017.00024/full